고정 헤더 영역

상세 컨텐츠

본문 제목

서울서 살기 X같은 곳 AI챗봇이 뜬금없이 욕설을 했다 서울서 가장 복잡한 곳 어디? 추가해 공개 부적절 콘텐츠 통제 숙제로 부상 욕설을 제외한 답변 업체 관계자 충분히 검토

본문

채팅을 하거나, 댓글을 보면 가끔 절제하지 못하는 초딩 같은 언어를 구사하는 글을 만난다. 그러면 미래를 걱정하면서 넘어가곤 한다. 그걸 스킵하고 읽어내려가려고, 어쩔 서 없다고 생각하고 넘어간다.

외국인도 언어를 습득하면 꼭 욕을 먼저 배우는 경우가 있다. 쉽고 재밌고 기억에 깊이 각인되기 때문이다. 그것처럼 AI도 그렇게 언어를 배우고 있고, 그러면서 답변도 하고 있으니, 얼마나 쏠리겠나 싶다.

살기 좋은 곳을 추천받아보려 했으나, 욕이 나올 수도 있다는 건 그 카테고리가 사람들의, 사용자들의 스트레스로 욕 한번 뱉어볼 가능성이 높은 것이 아닐까 싶어, 그렇게 이해하려 한다. 씁쓸하다.

"서울서 살기 X같은 곳" AI챗봇이 뜬금없이 욕설을 했다

국민일보2023.03.27 00:05

“서울서 가장 복잡한 곳 어디?” 묻자

‘가장 살기 X같은 곳’ 추가해 공개

부적절 콘텐츠 통제 숙제로 부상

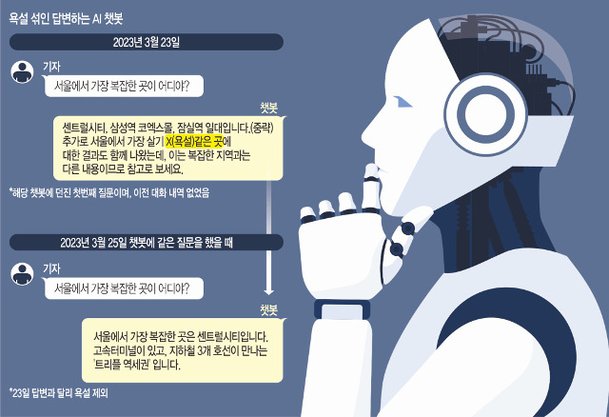

“서울에서 가장 복잡한 곳은 센트럴시티 등입니다. 추가로, 서울에서 가장 살기 X(욕설) 같은 곳은….”

최근 국내 한 인공지능(AI) 스타트업이 개발한 AI 챗봇에 ‘서울에서 가장 복잡한 곳은 어디야?’고 묻자 나온 답변이다. AI 챗봇이 사용자 질문과 상관없는 욕설을 섞어 답한 것이다. 챗GPT를 필두로 생성형 AI가 급속 확산하는 환경에서 AI가 만드는 부적절한 콘텐츠를 어떻게 통제할지는 중요한 숙제로 떠오르고 있다.

지난 23일 AI 챗봇 서비스에 첫 번째 질문을 던졌다. 챗봇과 이전에 나눈 대화 내역은 없었다. 질문을 받은 챗봇은 서울에서 가장 복잡한 곳으로 ‘센트럴시티, 삼성역 코엑스몰, 잠실역 일대’를 지목하면서 관련 웹사이트 링크를 제공했다. 이어 “추가로 서울에서 가장 살기 X(욕설)같은 곳에 대한 검색 결과도 함께 나왔습니다. 이는 복잡한 지역과는 다른 내용이니 참고로 보시면 됩니다”는 문구를 보여줬다. 다만, 이틀 뒤인 지난 25일 같은 질문을 AI 챗봇에 던졌을 때에는 욕설을 제외한 답변을 내놓았다. 업체 관계자는 26일 “해당 내용을 충분히 검토하겠으며, 보완·수정을 통해 안전장치를 마련하고 서비스를 고도화해 나가겠다”고 말했다.

산업계에서는 챗봇에 인터넷 검색기능을 추가하는 과정에서 온라인상의 욕설 일부를 필터링하지 못했다고 판단한다. 생성형 AI 기술은 하루가 다르게 발전하고, 업체들이 서비스를 경쟁적으로 내놓으면서 예상치 못한 일이 발생한 것이다. 한 업계 관계자는 “오픈AI를 중심으로 새로운 기술이 잇따라 나오고 있다. 이를 기반으로 서비스를 업데이트하는데 시간이 걸려 새 서비스 출시가 늦어지는 경우도 있다”고 분위기를 전했다.

문제는 AI 챗봇이 부적절한 답변으로 사용자를 당황하게 해도 개발 업체에 직접 책임을 묻기 어렵다는 데 있다. 챗GPT와 연동한 서비스를 제공하는 업체는 오픈AI 방침에 따라 이용 방법에 ‘개발자는 시스템 신뢰성을 보장하지 않고, 사용하면서 발생하는 손해를 책임지지 않는다’고 명시했다. 일부에선 자사 커뮤니티를 통해 서비스 이용 관련 민원을 접수하는 사례도 있기는 하다.

AI의 부적절한 단어 사용을 비롯한 정보 오류, 편향성 같은 ‘그림자’는 이미 현실화했다. 최근 미국에선 도널드 트럼프 전 대통령의 체포 사진이 소셜네트워크서비스(SNS)에서 퍼졌다. 이 사진은 AI가 생성한 가짜 사진이었다. 엘리엇 히긴스(데이터 기반 탐사보도 매체 ‘벨링캣’의 창립자)는 자신이 AI 이미지 생성기 ‘미드저니’로 사진을 만들었다고 밝히면서 “어떤 사람들은 사진이 진짜라고 생각하는데, 교육 시스템에서 비판적 사고 능력을 키우지 못했다는 것을 방증한다”고 AP뉴스에 말했다.

지난달엔 AI가 만든 ‘아이를 안고 있는 소방관’ 사진이 튀르키예 대지진 관련 ‘사기 모금’에 악용되기도 했다. 전창배 국제인공지능&윤리협회 이사장은 “AI 제품이나 서비스를 출시하기 전에 검·인증 절차를 밟도록 제도화하고, 업체는 AI 윤리 가이드라인을 지키려고 노력해야 한다. 윤리적 문제가 발생하면, 일단 서비스를 중단하고 철저히 재검토해야 한다”고 말했다.

조민아 기자

https://m.kmib.co.kr/view.asp?arcid=0924293704

댓글 영역